La unidad de investigación en inteligencia artificial de Meta anunció hoy dos desarrollos en torno a la coordinación de habilidades adaptativas y la replicación de la corteza visual que, según afirma, permitirán que los robots impulsados por IA funcionen en el mundo real sin datos del mundo real.

Según Meta, el anuncio constituye un paso importante en la creación de “agentes de IA corpóreos” de propósito general, capaces de interactuar con el mundo real sin intervención humana. El primer anuncio se refiere a la creación de una corteza visual artificial, llamada VC-1, entrenada en el conjunto de datos Ego4D, que consta de miles de videos de personas realizando tareas cotidianas.

Como explicaron los investigadores en el blog AI de Meta, la corteza visual es la región del cerebro que permite a los organismos convertir la visión en movimiento. Por lo tanto, una corteza visual artificial es un requisito clave para cualquier robot que deba realizar tareas basadas en lo que ve frente a él. Dado que VC-1 debe funcionar bien para un conjunto diverso de tareas sensoriomotoras en una amplia gama de entornos, el conjunto de datos Ego4D resultó especialmente útil, ya que contiene miles de horas de video de cámaras portátiles de participantes de la investigación en todo el mundo realizando actividades diarias, como cocinar, limpiar, hacer deporte y manualidades.

Según los investigadores, los organismos biológicos tienen una corteza visual de propósito general, y eso es lo que buscan para los agentes corpóreos. Por lo tanto, se propusieron crear uno que funcione bien en múltiples tareas, comenzando con Ego4D como conjunto de datos central y experimentando con la adición de conjuntos de datos adicionales para mejorar VC-1. “Dado que Ego4D se centra en actividades cotidianas como cocinar, jardinear y hacer manualidades, también consideramos conjuntos de datos de video egocéntricos que exploran casas y apartamentos”, escribieron los investigadores.

La corteza visual es solo un elemento de la IA corpórea. Para que un robot funcione completamente de forma autónoma en el mundo real, también debe ser capaz de manipular objetos del mundo real. Los robots deben poder navegar hacia un objeto, recogerlo, llevarlo a otro lugar y colocar el objeto, todo esto basado en lo que ve y escucha.

Para resolver esto, los expertos en IA de Meta colaboraron con investigadores del Instituto de Tecnología de Georgia para desarrollar una nueva técnica conocida como “coordinación de habilidades adaptativas”, donde los robots se entrenan completamente en simulaciones, y luego se transfieren esas habilidades al robot del mundo real.

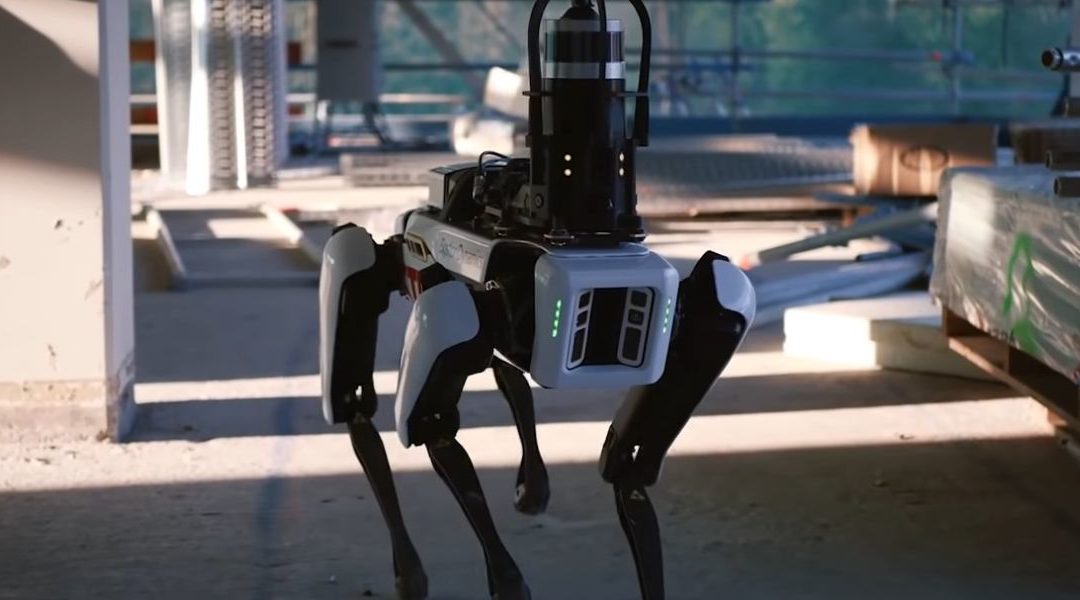

Meta demostró la efectividad de su técnica ASC en colaboración con Boston Dynamics Inc. El modelo ASC se integró con el robot Spot de Boston Dynamics, que posee sólidas capacidades de detección, navegación y manipulación, aunque solo con una gran intervención humana.

“Por ejemplo, recoger un objeto requiere que una persona haga clic en el objeto en la tableta del robot”, escribieron los investigadores. “Nuestro objetivo es construir modelos de IA que puedan percibir el mundo a través de la detección y los comandos de movimiento a bordo mediante las API de Boston Dynamics”.

El ASC fue probado en Spot utilizando el simulador Habitat, en entornos construidos con los conjuntos de datos HM3D y ReplicaCAD, que contienen escaneos en 3D de interiores de más de 1,000 hogares. Luego, se enseñó al robot Spot simulado a moverse por una casa nunca antes vista, recoger objetos fuera de lugar, llevarlos y colocarlos en el lugar correcto. Posteriormente, este conocimiento se transfirió a los robots Spot del mundo real, que realizaron las mismas tareas automáticamente, basándose en su noción aprendida de cómo son las casas.

“Cuando pusimos a prueba nuestro trabajo, utilizamos dos entornos del mundo real significativamente diferentes en los que se le pidió a Spot que reorganizara una variedad de objetos: un apartamento completamente amueblado de 185 metros cuadrados y un laboratorio universitario de 65 metros cuadrados”, escribieron los investigadores. “En general, ASC logró un rendimiento casi perfecto, con éxito en 59 de los 60 episodios, superando las inestabilidades del hardware, los fallos de agarre y las perturbaciones adversas como obstáculos en movimiento o caminos bloqueados”.

Los investigadores de Meta dicen que están compartiendo el modelo VC-1 de código abierto hoy, compartiendo sus aprendizajes detallados sobre cómo escalar el tamaño del modelo, los tamaños de los conjuntos de datos y más, en un documento acompañante. Mientras tanto, el próximo enfoque del equipo será tratar de integrar VC-1 con ASC para crear un sistema único que se acerque más a la verdadera IA corpórea.

Ilustración: fotograma, robot Spot en YouTube, sitio corporativo de Boston Dynamics.