Google ha anunciado hoy la disponibilidad general de una nueva familia de máquinas virtuales (VM) Compute Engine A2 basadas en las unidades de procesamiento gráfico Ampere A100 Tensor Core de Nvidia Corp. Las nuevas VM son las primeras del mundo que incluyen 16 GPU A100 de Nvidia en una sola máquina virtual, lo que las convierte en la mayor instancia de GPU de un solo nodo disponible en cualquier proveedor de infraestructura de nube pública, sostiene Google.

Las potentes instancias están configuradas para las cargas de trabajo más exigentes que realizan las organizaciones, permitiéndoles escalar y ampliar diversos trabajos de aprendizaje automático (ML) y computación de alto rendimiento de forma más eficiente y a un menor coste, señala Google.

En una entrada del blog, los directores de producto de Google, Bharath Parthasarathy y Chris Kleban, explican que los clientes también pueden elegir configuraciones a menor escala de las VM A2, con opciones de una, dos, cuatro y ocho GPUs por máquina virtual para ofrecer mayor flexibilidad.

“Una sola VM A2 admite hasta 16 GPU NVIDIA A100, lo que facilita a los investigadores, científicos de datos y desarrolladores la obtención de un rendimiento mucho mayor para sus cargas de trabajo de computación CUDA escalables, como el entrenamiento de aprendizaje automático, la inferencia y la HPC”, afirman Parthasarathy y Kleban. “La familia A2 VM en Google Cloud Platform está diseñada para satisfacer las aplicaciones HPC más exigentes de hoy en día, como las simulaciones CFD con Altair ultraFluidX”.

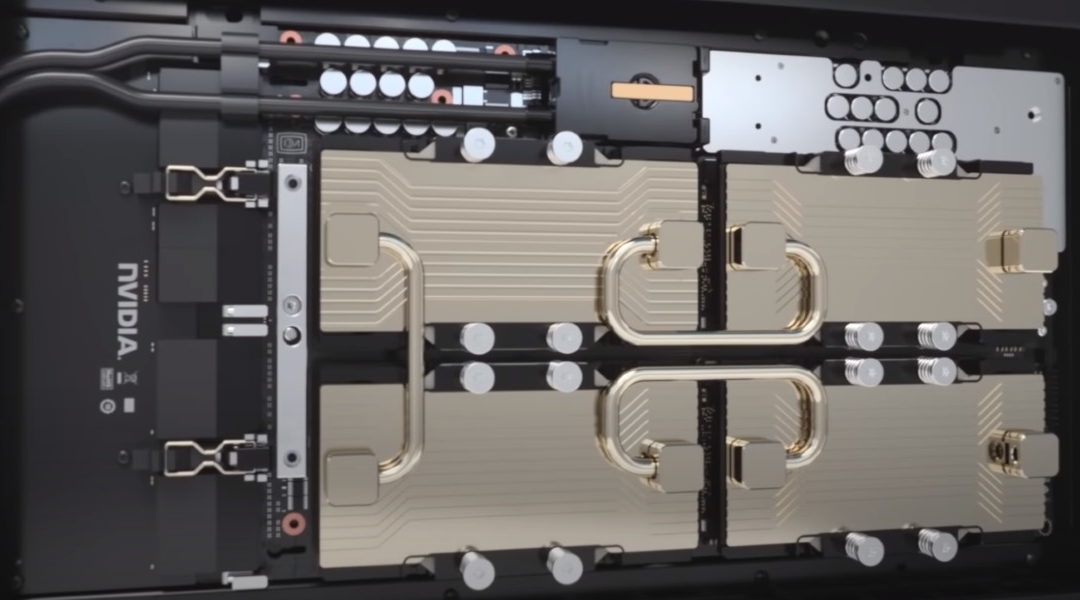

Google también destacó que puede proporcionar a los clientes “clusters de GPU ultra grandes” de miles de GPUs disponibles para los trabajos de formación de aprendizaje automático distribuido más exigentes. Asimismo, afirmó que sus máquinas virtuales están unidas por el tejido NVLink de Nvidia, lo que las hace únicas entre las ofertas de máquinas virtuales de cualquier proveedor de la nube. “Por lo tanto, si necesitas escalar cargas de trabajo grandes y exigentes, puedes empezar con una GPU A100 y llegar hasta 16 GPUs sin tener que configurar múltiples VMs para un entrenamiento de ML de un solo nodo”, dijeron Parthasarathy y Kleban.

Según Google, una sola A100 en Google Cloud ofrece un aumento de rendimiento de más de 10 veces en el modelo de preentrenamiento BERT Large en comparación con la generación anterior de GPU Nvidia V100, al tiempo que consigue un escalado lineal que va de ocho a 16 formas de GPU.

El Instituto Allen para la Inteligencia Artificial, entidad sin fines de lucro, dijo que fue capaz de acelerar su investigación de IA por cuatro veces usando las VMs A2. “Es prácticamente plug and play”, dijo el ingeniero principal del Instituto Allen, Dirk Groeneveld. “A fin de cuentas, el A100 en Google Cloud nos da la capacidad de hacer drásticamente más cálculos por dólar, lo que significa que podemos hacer más experimentos, y hacer uso de más datos”.

Las instancias A2 con GPU A100 de Nvidia ya están disponibles en las regiones de Estados Unidos-centro1, Asia-sudeste1 y Europa-oeste4, y que más regiones estarán en línea a finales de este año.