El día de hoy, NVIDIA presentó NVIDIA DGX Station™ A100, el primer servidor para grupos de trabajo a petaescala del mundo. DGX Station A100, la segunda generación del innovador sistema de inteligencia artificial, acelera las exigentes cargas de trabajo de machine learning y ciencia de datos para los equipos que trabajan en oficinas corporativas, instalaciones de investigación, laboratorios u oficinas desde casa en todas partes.

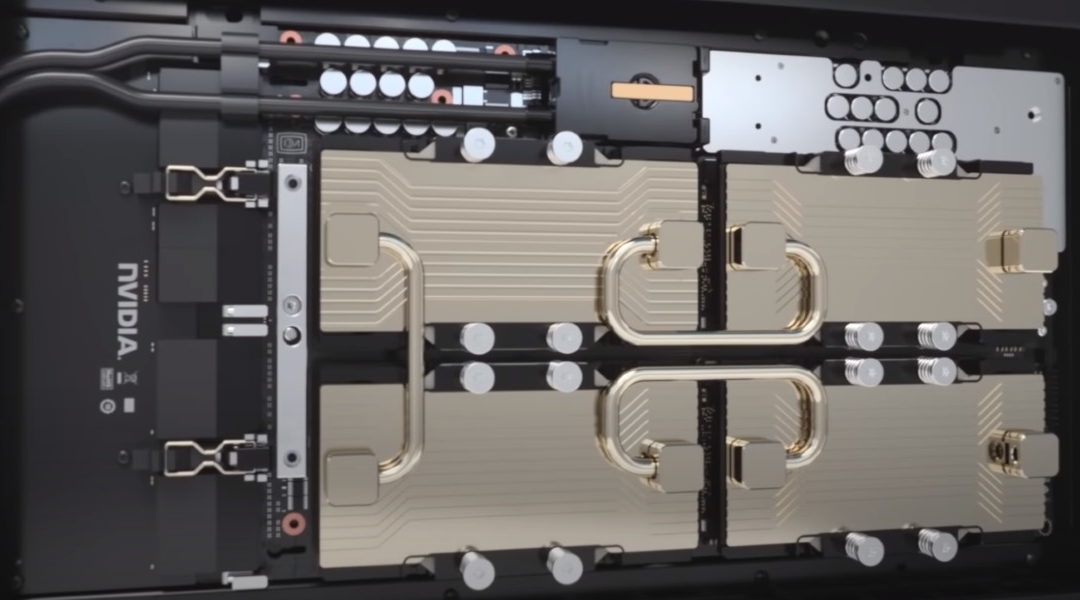

DGX Station A100 cuenta con 2.5 petaflops de rendimiento de IA y es el único servidor de grupos de trabajo con cuatro de las GPUs NVIDIA® A100 Tensor Core más recientes totalmente interconectadas con NVIDIA NVLink®, lo que proporciona hasta 320 GB de memoria de GPU para acelerar los avances en la IA y la ciencia de datos empresariales.

DGX Station A100 es también el único servidor para grupos de trabajo compatible con la tecnología de múltiples instancias de GPU de NVIDIA (MIG). Con MIG, una sola DGX Station A100 proporciona hasta 28 instancias de GPU separadas para ejecutar trabajos en paralelo y admitir varios usuarios sin afectar el rendimiento del sistema.

“DGX Station A100 saca la IA del data center con un sistema de clase de servidor que se puede conectar en cualquier lugar”, dijo Charlie Boyle, vicepresidente y gerente general de sistemas DGX de NVIDIA. “Los equipos de investigadores de ciencia de datos e inteligencia artificial pueden acelerar su trabajo utilizando la misma pila de software que los sistemas NVIDIA DGX A100, lo que les permite escalar fácilmente desde el desarrollo hasta la implementación”.

DGX Station Potencia la Innovación de IA

Organizaciones de todo el mundo han adoptado DGX Station para impulsar la inteligencia artificial y la ciencia de datos en industrias como la educación, los servicios financieros, el gobierno, la atención médica y el comercio minorista. Estos líderes de IA incluyen:

- BMW Group Production está usando NVIDIA DGX Stations para explorar los resultados más rápido, a medida que desarrolla e implementa modelos de IA que mejoran las operaciones.

- DFKI, el Centro Alemán de Investigación de Inteligencia Artificial, está utilizando DGX Station para construir modelos que abordan desafíos críticos para la sociedad y la industria, incluidos los sistemas de visión de computación que ayudan a los servicios de emergencia a responder rápidamente a desastres naturales.

- Lockheed Martin está utilizando DGX Station para desarrollar modelos de inteligencia artificial que utilizan datos de sensores y registros de servicios para predecir la necesidad de mantenimiento y así mejorar el tiempo de actividad de manufactura, aumentar la seguridad de los trabajadores y reducir los costos operativos.

- Pacific Northwest National Laboratory está usando NVIDIA DGX Stations para llevar a cabo investigaciones con fondos federales que fomentan la seguridad nacional. PNNL se enfoca en la innovación tecnológica de resiliencia energética y seguridad nacional. Es un centro de HPC líder en EE. UU. para el descubrimiento científico, la resiliencia energética, la química, las ciencias de la Tierra y el análisis de datos.

- NTT Docomo, el operador móvil líder de Japón que cuenta con más de 79 millones de suscriptores, utiliza DGX Station para desarrollar servicios innovadores basados en inteligencia artificial, como su solución de reconocimiento de imágenes.

Una Supercomputadora de IA en Todas Partes

Si bien DGX Station A100 no requiere alimentación ni enfriamiento de grado de data center, es un sistema de clase de servidor que incluye las mismas capacidades de administración remota que los sistemas de data centers NVIDIA DGX A100. Los administradores de sistema pueden realizar fácilmente cualquier tarea de gestión a través de una conexión remota cuando los científicos de datos y los investigadores están trabajando en casa o en laboratorios.

DGX Station A100 está disponible con cuatro GPUs NVIDIA A100 Tensor Core de 80 GB o 40 GB. Esto brinda opciones para que los equipos de investigación de ciencia de datos e inteligencia artificial seleccionen un sistema de acuerdo con sus cargas de trabajo y presupuestos únicos.

Para impulsar modelos de IA conversacionales complejas, como la inferencia de BERT Large, DGX Station A100 es más de 4 veces más rápido que la generación anterior de DGX Station. Ofrece un aumento de rendimiento de casi 3 veces para el entrenamiento de IA de BERT Large.

Duplicar la Memoria de la GPU para AI, HPC

Para las cargas de trabajo avanzadas de data centers, los sistemas DGX A100 estarán disponibles con las nuevas GPU NVIDIA A100 de 80 GB. Esto duplica la capacidad de memoria de la GPU a 640 GB por sistema, a fin de permitir que los equipos de inteligencia artificial aumenten la precisión con conjuntos de datos y modelos más grandes.

Los nuevos sistemas NVIDIA DGX A100 de 640 GB también se pueden integrar en la solución NVIDIA DGX SuperPODTM para empresas, lo que permitirá a las organizaciones desarrollar, entrenar e implementar enormes modelos de IA en supercomputadoras de IA listas para usar, disponibles en unidades de 20 sistemas DGX A100.

Las primeras entregas de los sistemas NVIDIA DGX SuperPOD con DGX A100 de 640 GB incluirán la supercomputadora Cambridge-1, que se está instalando en el Reino Unido para potenciar la investigación de la salud, y la nueva supercomputadora de IA HiPerGator de la Universidad de Florida , que impulsará el descubrimiento infundido de IA en todo el estado.

Disponibilidad

Los sistemas NVIDIA DGX Station A100 y NVIDIA DGX A100 de 640 GB estarán disponibles este trimestre a través de la Red de socios de NVIDIA de todo el mundo. Hay una opción de actualización disponible para los clientes de NVIDIA DGX A100 de 320 GB.