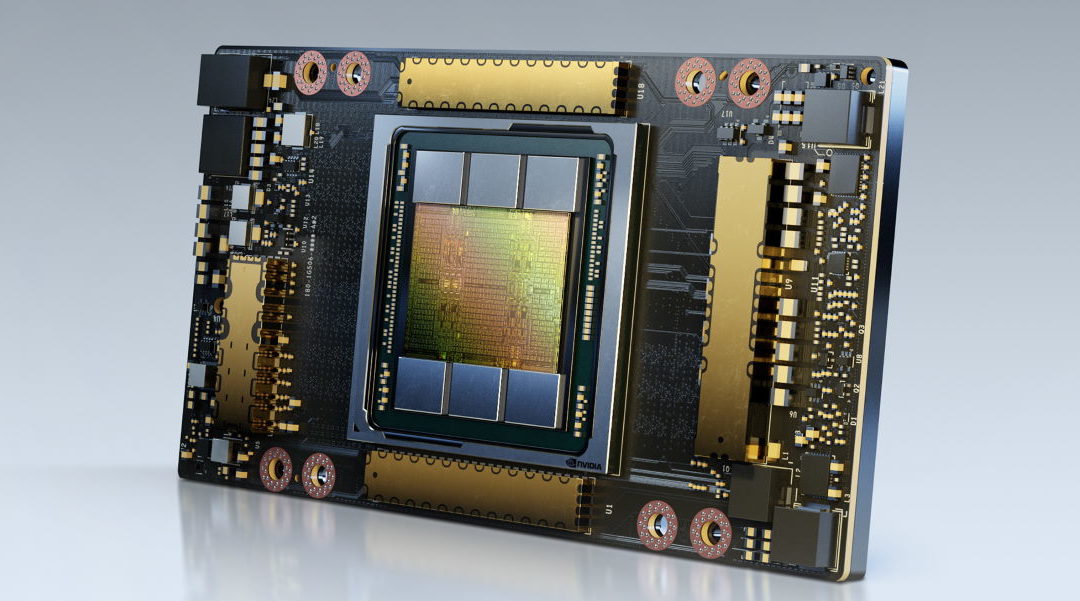

La nueva GPU NVIDIA A100 de 80 gigabytes viene con el doble de memoria que su predecesora, la GPU estándar A100 de 40 GB que se lanzó a principios de este año, lo que le permite ofrecer más de 2 terabytes por segundo de ancho de banda de memoria. El resultado es que la GPU A100 puede procesar el doble de datos en la misma cantidad de tiempo, acelerando las cargas de trabajo de la IA y aceptando datasets mucho más voluminosos, dijo Nvidia.

“Lograr resultados de vanguardia en la investigación de HPC e IA requiere el desarrollo de modelos más grandes; sin embargo, estos exigen más capacidad de memoria y ancho de banda que nunca”, dijo Bryan Catanzaro, vicepresidente de investigación de deep learning aplicado de NVIDIA. “La GPU A100 de 80 GB proporciona el doble de memoria que su predecesora, que se lanzó hace solo seis meses, y rompe la barrera de los 2 TB por segundo, lo que permite a los investigadores abordar los desafíos científicos y de big data más importantes del mundo”.

La GPU NVIDIA A100 de 80 GB está disponible en los sistemas NVIDIA DGXTM A100 y NVIDIA DGX StationTM A100, que también se anunciaron hoy y se esperan que se envíen este trimestre.

Se espera que los principales proveedores de sistemas, como Atos, Dell, Fujitsu, GIGABYTE, Hewlett Packard Enterprise, Inspur, Lenovo, Quanta y Supermicro, comiencen a ofrecer sistemas desarrollados con las placas base integradas HGX A100 con configuraciones de cuatro (4) u ocho (8) GPUs A100 de 80 GB en la primera mitad del 2021.

Impulsar cargas de trabajo hambrientas de datos

La GPU A100 de 80 GB se basa en las diversas capacidades de la A100 de 40 GB y es ideal para realizar una amplia gama de aplicaciones con enormes requisitos de memoria de datos.

Para el entrenamiento de IA, los modelos de sistemas de recomendación como DLRM tienen enormes tablas que representan miles de millones de usuarios y cientos de millones de productos. El A100 de 80 GB ofrece una aceleración de hasta 3 veces, por lo que las empresas pueden reentrenar rápidamente estos modelos para brindar recomendaciones altamente precisas.

El A100 de 80 GB también permite el entrenamiento de los modelos más grandes con más parámetros que se ajustan a un solo servidor con HGX, como GPT-2, un modelo de procesamiento de idiomas naturales con capacidad de texto generativo sobrehumano. Esto elimina la necesidad de datos o modelos de arquitecturas paralelas que pueden llevar mucho tiempo implementar y ralentizar su ejecución en varios nodos.

Gracias a su tecnología de GPU de instancias múltiples (MIG), A100 se puede particionar en hasta siete instancias de GPU, cada una con 10 GB de memoria. Esto proporciona un aislamiento de hardware seguro y maximiza la utilización de la GPU para una variedad de cargas de trabajo más pequeñas. Para la inferencia de IA de modelos de reconocimiento automático de voz como RNN-T, una sola instancia de MIG A100 de 80 GB puede dar servicio a lotes mucho más grandes, lo que ofrece un rendimiento de inferencia 1.25 veces mayor en producción.

En una evaluación del análisis de big data para la industria del comercio minorista, en el rango de tamaño de terabytes, la A100 de 80 GB aumenta el rendimiento hasta 2 veces, lo que la convierte en una plataforma ideal para brindar información rápida sobre los conjuntos de datos más grandes. Las empresas pueden tomar decisiones clave en tiempo real, ya que los datos se actualizan de forma dinámica.

Para aplicaciones científicas, como la previsión meteorológica y la química cuántica, la A100 de 80 GB puede ofrecer una enorme aceleración. Quantum Espresso, una simulación de materiales logró un rendimiento cerca de 2 veces con un solo nodo de A100 de 80 GB.

“La capacidad y el ancho de banda de memoria amplios y rápidos son vitales para lograr un alto rendimiento en aplicaciones de supercomputación”, dijo Satoshi Matsuoka, director del Centro RIKEN de Ciencias Computacionales. “La NVIDIA A100 con 80 GB de memoria de GPU HBM2e, que proporciona el ancho de banda de 2 TB por segundo más rápido del mundo, ayudará a ofrecer un gran impulso en el rendimiento de las aplicaciones”.

Características clave de A100 de 80 GB

La A100 de 80 GB incluye las diversas e innovadoras características de la arquitectura NVIDIA Ampere:

- Tensor Cores de 3.ª generación: Proporciona un rendimiento de AI hasta 20 veces superior, en comparación con la generación anterior de Volta, gracias a un nuevo formato TF32, 2.5 veces superior en FP64 para HPC y 20 veces superior en INT8 para la inferencia de AI. También admite el formato de datos BF16.

- Memoria de GPU HBM2e más grande y rápida: Duplica la capacidad de memoria y es el primero dispositivo de la industria en ofrecer más de 2 TB por segundo de ancho de banda de memoria.

- Tecnología MIG: Duplica la memoria por instancia aislada, para proporcionar hasta siete MIG con 10 GB cada uno.

- Baja densidad estructural: Ofrece hasta el doble de aceleración en las inferencias de modelos con baja densidad.

- NVLink y NVSwitch de tercera generación: Proporciona el doble de ancho de banda de GPU a GPU que la tecnología de interconexión de la generación anterior, lo que acelera las transferencias de datos a la GPU para cargas de trabajo con uso intensivo de datos a 600 gigabytes por segundo.

Plataforma de supercomputo NVIDIA HGX AI

La GPU A100 de 80 GB es un elemento clave de la plataforma de supercomputación NVIDIA HGX AI, que reúne toda la potencia de las GPUs de NVIDIA, NVIDIA NVLink®, las redes NVIDIA InfiniBand y una pila de software NVIDIA de IA y HPC totalmente optimizada para proporcionar el mayor rendimiento de las aplicaciones. Permite a los investigadores y científicos combinar HPC, análisis de datos y métodos de computación de deep learning para avanzar en el progreso científico.