NVIDIA ha anunciado hoy que su plataforma de computación de IA ha vuelto a batir récords de rendimiento en la última ronda de MLPerf, ampliando su liderazgo en el único estándar de comparación independiente de la industria, que mide el rendimiento de la IA en hardware, software y servicios.

NVIDIA ganó todas las pruebas en las seis áreas de aplicación para centros de datos y sistemas de computación en el borde, comprendidas en la segunda versión de MLPerf Inference. Aparte de incluir las dos pruebas originales sobre visión artificial, la comparativa se ha expandido para cubrir las cuatro áreas de mayor crecimiento en IA: sistemas de recomendación, comprensión del lenguaje natural, reconocimiento del habla e imágenes médicas.

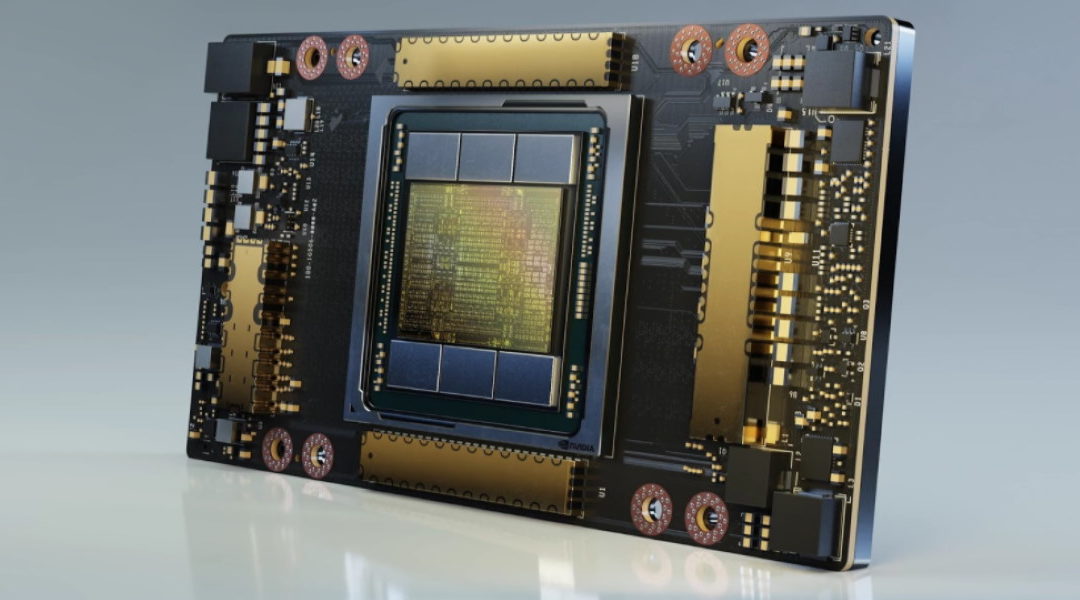

Organizaciones de una amplia gama de industrias ya están aprovechando el excepcional rendimiento inferencial de la GPU NVIDIA® A100 Tensor Core para llevar la IA desde sus grupos de investigación a las operaciones diarias. Instituciones financieras están usando la IA conversacional para responder más rápidamente las preguntas de los clientes; minoristas están usando la IA para mantener sus estanterías abastecidas; y proveedores de atención sanitaria están usando la IA para analizar millones de imágenes médicas para identificar con mayor precisión las enfermedades y ayudar a salvar vidas.

“Nos encontramos en un punto de inflexión ya que todas las industrias buscan mejores formas de aplicar la IA para ofrecer nuevos servicios y hacer crecer su negocio”, dijo Ian Buck, vicepresidente y gerente general de computación acelerada en NVIDIA.”El trabajo que hemos hecho para lograr estos resultados en el MLPerf brinda a las empresas un nuevo nivel de rendimiento de la IA para mejorar nuestra vida cotidiana”.

Los últimos resultados de MLPerf surgen en momentos en que la presencia de NVIDIA en el ámbito de la inferencia en IA ha crecido radicalmente. Hace cinco años, sólo un reducido grupo de las principales empresas de alta tecnología utilizaban las GPU para inferencia. Ahora, con la plataforma IA de NVIDIA disponible a través de todos los principales proveedores de infraestructuras de nubes y centros de datos, empresas que representan una amplia gama de sectores están utilizando la plataforma para mejorar sus operaciones comerciales y ofrecer servicios adicionales.

Asimismo, por primera vez, las GPU de NVIDIA ofrecen más capacidad de inferencia de IA en la nube pública que las CPU. La capacidad total de cómputo en inferencia de IA en la nube se ha multiplicado aproximadamente por 10 cada dos años para las GPU de NVIDIA.

NVIDIA lleva la inferencia de la IA a otro nivel

NVIDIA y sus socios enviaron sus resultados de MLPerf 0.7 utilizando la plataforma de aceleración de NVIDIA, que incluye las GPU NVIDIA para centros de datos, los aceleradores para el borde y el software optimizado de NVIDIA.

NVIDIA A100, presentada a principios de este año y dotada de Tensor Cores y la tecnología de GPU multi-instancia, aumentó su ventaja en la prueba ResNet-50, superando en 30 veces a las CPU, frente a las 6 veces de la última ronda. Además, la A100 superó a las CPU más recientes con un desempeño 237 veces mayor en la prueba de recomendación para la inferencia en centros de datos, incorporada recientemente, según la versión 0.7 de MLPerf Inference.

Esto significa que un solo sistema NVIDIA DGX A100™ puede proporcionar el mismo rendimiento que aproximadamente 1.000 servidores de CPU de doble socket, ofreciendo a los clientes una extrema eficiencia de costes al llevar sus modelos de recomendación de IA desde el ámbito de la investigación a la producción.

Los análisis también muestran que la GPU NVIDIA T4 Tensor Core sigue siendo una sólida plataforma de inferencia para las empresas de punta, los servidores edge y las instancias cloud rentables. Las GPU T4 de NVIDIA tienen un desempeño 28 veces superior a las CPU en las mismas pruebas. De igual modo, el Jetson AGX Xavier de NVIDIA es el líder de rendimiento entre los dispositivos edge basados en SoC.

Para conseguir estos resultados se necesitaba una pila de software altamente optimizada que incluyera el optimizador de inferencia TensorRT™ de NVIDIAy el software de servicio de inferencia Triton de NVIDIA, ambos disponibles en NGC, el catálogo de software de NVIDIA.

Además de las muestras aportadas por NVIDIA, 11 partners de NVIDIA enviaron un total de 1.029 resultados utilizando GPU de NVIDIA, lo que representa más del 85 por ciento del total de colaboraciones en las categorías de centros de datos y borde.