Cerebras Systems, empresa dedicada a la computación IA de alto rendimiento, desveló el 22 de junio su capacidad para entrenar modelos con hasta 20.000 millones de parámetros en un único sistema, denominado CS-2. Según la empresa, se trata de una hazaña no lograda anteriormente por ningún otro dispositivo. Cerebras reduce el tiempo de ingeniería de sistemas necesario para ejecutar grandes modelos de procesamiento del lenguaje natural (PLN) de meses a minutos al permitir que un solo CS-2 entrene estos modelos. También elimina una de las características más fastidiosas de la PNL: dividir el modelo entre cientos o miles de modestas unidades de procesamiento gráfico (GPU).

“Está demostrado que los modelos más grandes son más precisos en PNL”. Pero, en el pasado, sólo unas pocas empresas disponían de los recursos y la capacidad para dividir estos enormes modelos y distribuirlos entre cientos o miles de unidades de procesamiento gráfico”, afirma Andrew Feldman, CEO y cofundador de Cerebras Systems. “Como resultado, sólo unas pocas organizaciones eran capaces de entrenar enormes modelos de PNL: era demasiado caro, requería mucho tiempo y estaba fuera del alcance del resto de la industria”. Hoy, nos complace democratizar el acceso a GPT-3 1,3B, GPT-J 6B, GPT-3 13B y GPT-NeoX 20B, lo que permite a toda la comunidad de la IA construir y entrenar grandes modelos en cuestión de minutos en un solo CS-2″.

“GSK genera conjuntos de datos extraordinariamente enormes a través de su investigación genómica y genética, y estos conjuntos de datos requieren nuevos equipos de aprendizaje automático”, afirmó Kim Branson, vicepresidente senior de Inteligencia Artificial y Aprendizaje Automático de GSK. “El Cerebras CS-2 es un componente fundamental que permite a GSK entrenar modelos lingüísticos utilizando conjuntos de datos biológicos a escalas y tamaños antes imposibles”. Estos modelos centrales sirven de columna vertebral para muchos de nuestros sistemas de IA y son fundamentales para el descubrimiento de medicamentos transformadores”.

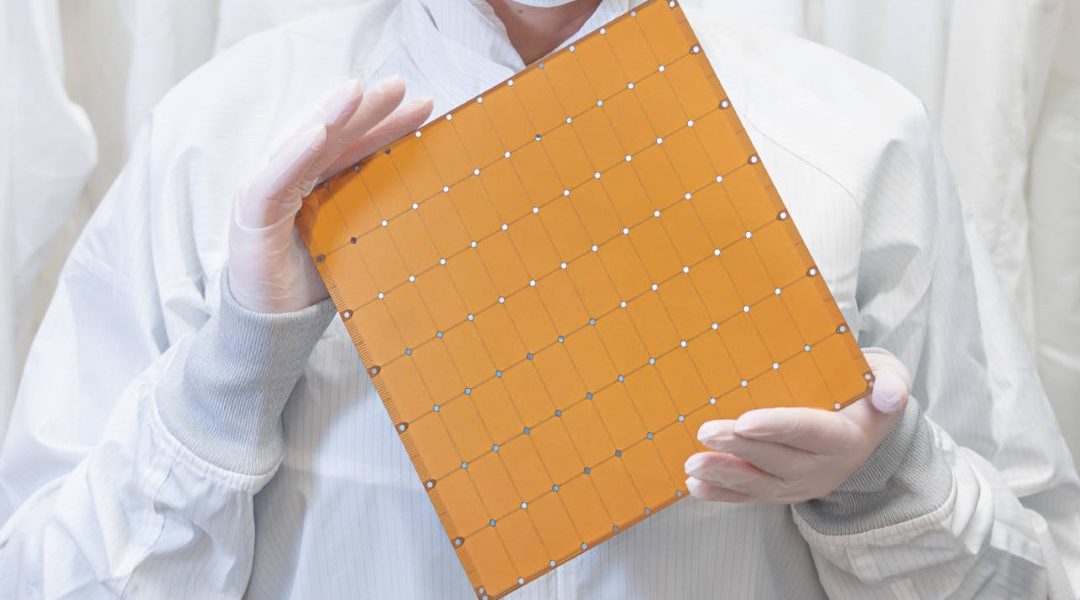

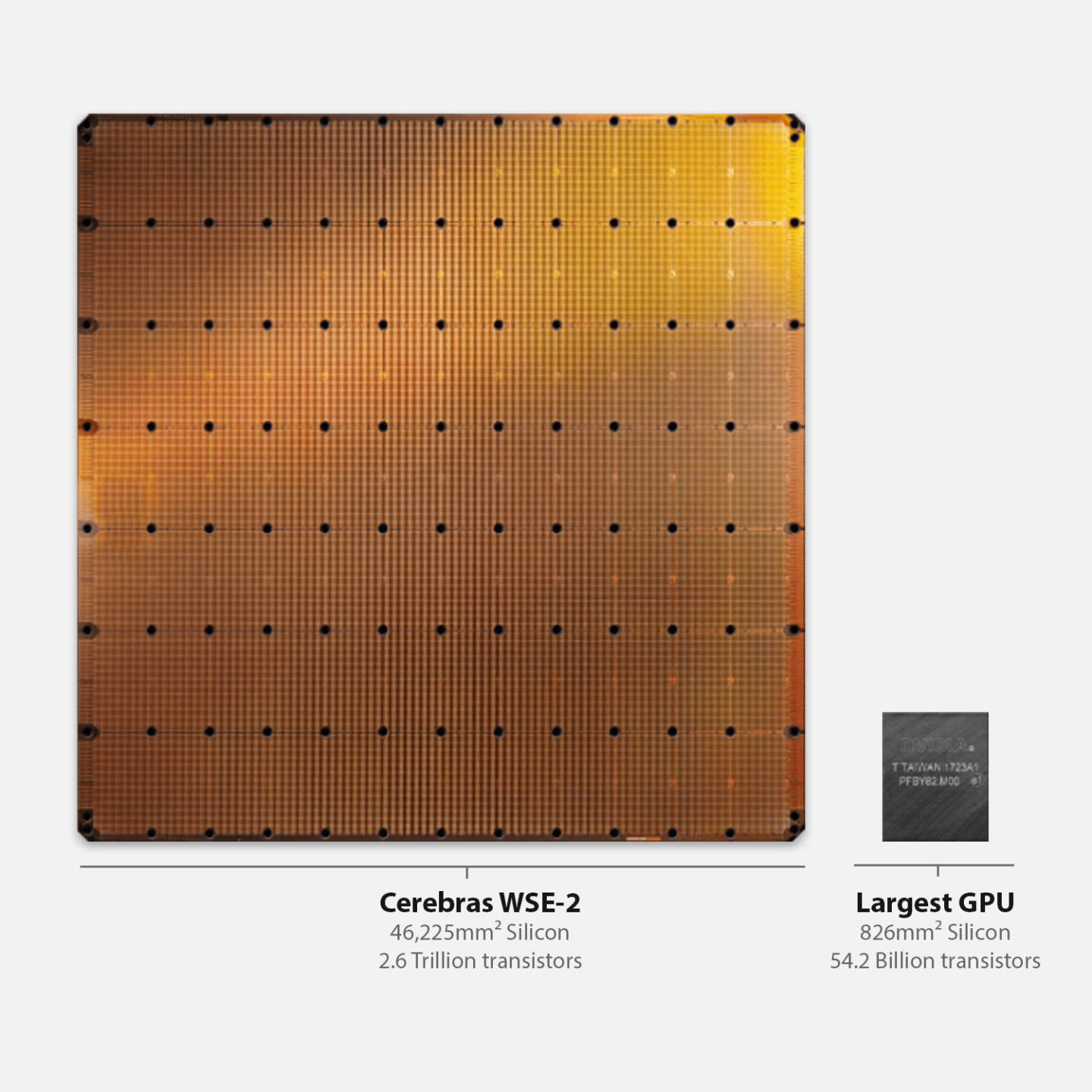

Estas capacidades, pioneras en el mundo, son posibles gracias a la combinación de los recursos computacionales y del motor Wafer Scale Engine-2 (WSE-2size ) de Cerebras, así como a las extensiones de la arquitectura de software Weight Streaming, disponibles con el lanzamiento de la versión R1.4 de la plataforma de software de Cerebras, CSoft.

El entrenamiento de la IA es sencillo cuando un modelo cabe en una sola CPU. Sin embargo, cuando un modelo tiene más parámetros de los que puede contener la memoria o una capa exige más cálculo del que puede realizar un solo procesador, la complejidad se dispara. El modelo debe dividirse y distribuirse entre cientos o miles de GPU. Se trata de un proceso arduo que puede durar meses. Para empeorar las cosas, el procedimiento es único para cada par de clusters de computación de red, por lo que el trabajo no es transferible entre clusters de computación o redes neuronales. Es realmente único.

El procesador Cerebras WSE-2 es el más grande jamás desarrollado. Es 56 veces más grande, con 2,55 billones de transistores más, y 100 veces el número de núcleos de procesamiento que la mayor GPU. El tamaño y la capacidad de cálculo del WSE-2 permiten que quepan todas las capas de las redes neuronales más complejas. La memoria y el cálculo están separados en la arquitectura Cerebras Weight Streaming, lo que permite que la memoria (que se utiliza para almacenar los parámetros) aumente independientemente del cálculo. Como resultado, un solo CS-2 puede ejecutar modelos con cientos de miles de millones, si no billones, de parámetros.

En cambio, las unidades de procesamiento gráfico (GPU) tienen una cantidad fija de memoria por GPU. Si el modelo requiere más parámetros de los que puede contener la memoria, hay que comprar procesadores gráficos adicionales y distribuir el trabajo entre numerosas GPU. El resultado es una explosión de complejidad. La solución de Cerebras es mucho más sencilla y elegante: al desacoplar el cálculo de la memoria, la arquitectura Weight Streaming permite que los modelos con cualquier número de parámetros se ejecuten en un solo CS-2.